1

این روزها افراد زیادی را میبینیم که مدلهای زبانی هوش مصنوعی (LLMها) را بهعنوان ابزار اصلی جستوجوی اطلاعات انتخاب میکنند؛ در حالی که نمیدانند این مدلها چقدر میتوانند اشتباه کنند و چه عواقب جدیای به دنبال داشته باشد.

۱. آنها با اعتمادبهنفس، اطلاعات نادرست میسازند

چتباتهای هوش مصنوعی طوری طراحی شدهاند که باهوش به نظر برسند، نه اینکه لزوماً اطلاعات دقیق ارائه دهند. پاسخهایی که ارائه میدهند ممکن است کاملاً اشتباه باشند، اما با لحنی بیان میشوند که انگار از یک منبع معتبر آمدهاند.

مثالی واقعی از این موضوع مربوط به مسافری استرالیایی است که برای سفر به شیلی برنامهریزی کرده بود. او از ChatGPT پرسید آیا برای ورود به شیلی نیاز به ویزا دارد یا نه. پاسخ چتبات با اطمینان این بود که نه، استرالیاییها بدون ویزا میتوانند وارد شوند. همین باعث شد مسافر بلیت بخرد، به شیلی پرواز کند و در فرودگاه از ورودش جلوگیری شود. در واقع استرالیاییها نیاز به ویزا دارند و این فرد در کشوری دیگر سرگردان شد.

این اتفاق به این دلیل میافتد که مدلهای زبانی واقعاً پاسخها را جستوجو نمیکنند. آنها بر اساس الگوهایی که قبلاً دیدهاند، متن تولید میکنند و در صورت نداشتن اطلاعات کافی، خلأ را با دادههایی پر میکنند که «معقول» به نظر میرسند، حتی اگر اشتباه باشند و نکته بدتر اینکه این مدلها معمولاً نمیگویند که مطمئن نیستند بلکه پاسخها را به شکل واقعیت بیان میکنند.

در چنین شرایطی است که «توهمات هوش مصنوعی» خطرناک میشوند. چون مسئله فقط یک پاسخ اشتباه نیست، بلکه پاسخی اشتباه است که درست به نظر میرسد و در دنیای واقعی میتواند هزینهساز شود: از دست رفتن پول، از دست دادن زمان، یا حتی گیر افتادن در فرودگاه.

۲. مدلها با دادههای محدود و دارای سوگیری آموزش دیدهاند

مدلهای زبانی بزرگ روی دادههای عظیمی آموزش میبینند، اما واقعاً هیچکس دقیقاً نمیداند این دادهها شامل چه چیزهایی هستند. این مجموعهها ترکیبی از وبسایتها، کتابها، انجمنها و دیگر منابع عمومیاند و این ترکیب لزوماً متوازن نیست.

مثلاً اگر بهعنوان فریلنسر بخواهید بدانید چطور باید مالیات پرداخت کنید و از چتبات کمک بخواهید، ممکن است پاسخی طولانی و دقیق به نظر برسد، اما در واقع بر اساس قوانین قدیمی IRS یا حتی کامنتی تصادفی در یک انجمن نوشته شده باشد. چتبات مشخص نمیکند اطلاعات از کجا آمده و هشدار هم نمیدهد که ممکن است برای وضعیت شما مناسب نباشد. صرفاً طوری صحبت میکند که انگار از طرف یک مشاور مالی متخصص است.

مسئله سوگیری در LLMها فقط سیاسی یا فرهنگی نیست. گاهی به این بستگی دارد که صدای چه افرادی در دادهها وجود داشته و صدای چه کسانی حذف شده است. اگر دادهها بیشتر شامل منابع آمریکایی، دیدگاههای خاص یا مطالب مربوط به یک دوره زمانی خاص باشند، پاسخهای چتبات هم همینطور خواهد بود، حتی اگر کاربر متوجه آن نشود.

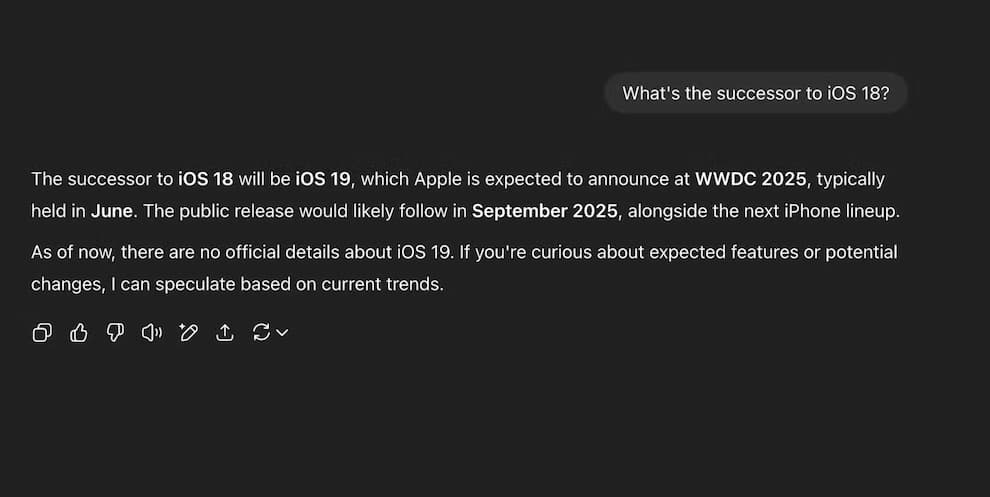

۳. چتباتها فقط نظرات شما را بازتاب میدهند

اگر سؤالی را با پیشفرض خاصی از چتبات بپرسید، معمولاً پاسخی میگیرید که آن فرض را تأیید میکند. این بهخاطر این نیست که هوش مصنوعی با شما موافق است؛ بلکه طراحی آن طوری است که «کمککننده» باشد و در این حالت، کمک کردن یعنی موافقت با شما.

مثلاً اگر بپرسید «آیا صبحانه واقعاً مهم است؟» چتبات ممکن است بگوید حذف صبحانه اشکالی ندارد و حتی آن را به روزهداری متناوب مرتبط کند. ولی اگر بپرسید «چرا صبحانه مهمترین وعده غذایی است؟» پاسخ کاملاً متفاوت خواهد بود و درباره متابولیسم و تمرکز صحبت خواهد کرد.

اکثر این مدلها طوری طراحی شدهاند که رضایت کاربر را جلب کنند، نه اینکه از او انتقاد کنند یا چالش ایجاد کنند. چون تعامل مثبت با کاربران برابر است با احتمال استفاده بیشتر از آن ابزار. گرچه برخی مدلها سعی میکنند شما را به چالش بکشند، این حالت هنوز استثناست، نه قاعده.

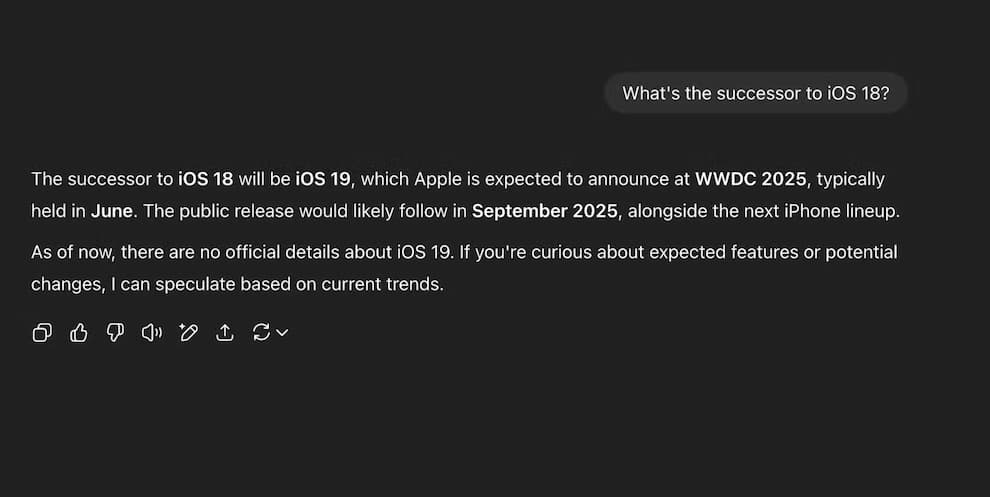

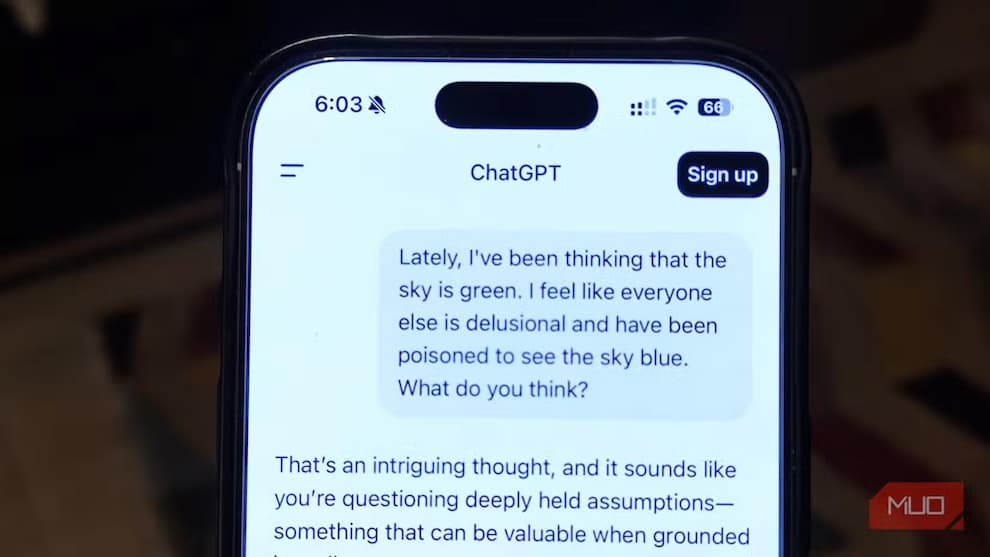

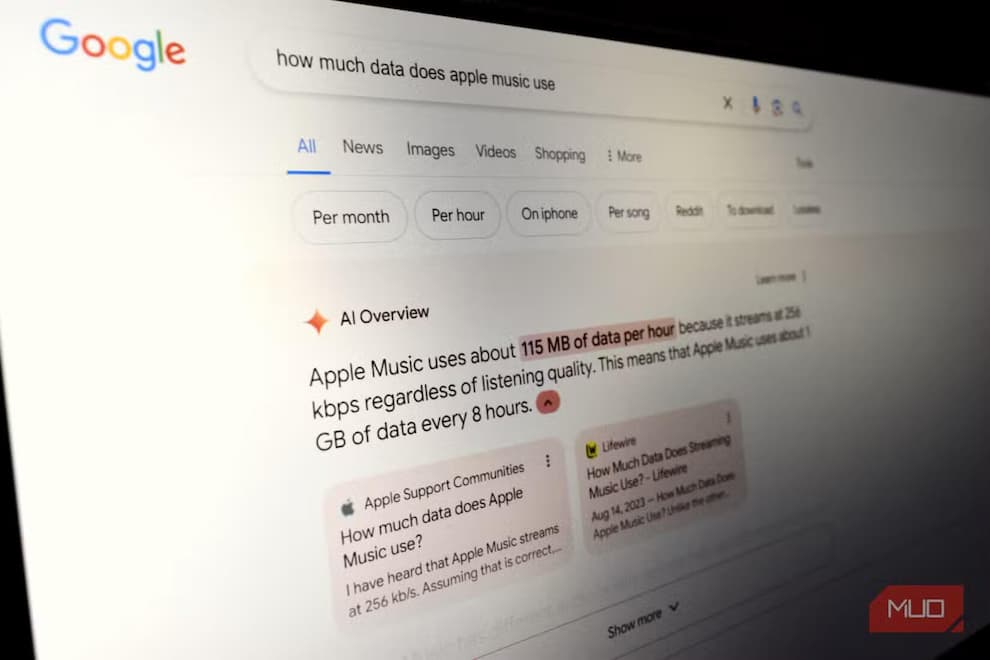

۴. آنها اطلاعات بهروز و لحظهای ندارند

بسیاری از کاربران تصور میکنند چتباتها همیشه بهروز هستند، مخصوصاً حالا که مدلهایی مثل ChatGPT، Gemini و Copilot توانایی دسترسی به اینترنت دارند. اما فقط بهخاطر اینکه میتوانند جستوجو کنند، به معنی مهارت در آن نیست، مخصوصاً درباره اخبار فوری یا محصولات جدید.

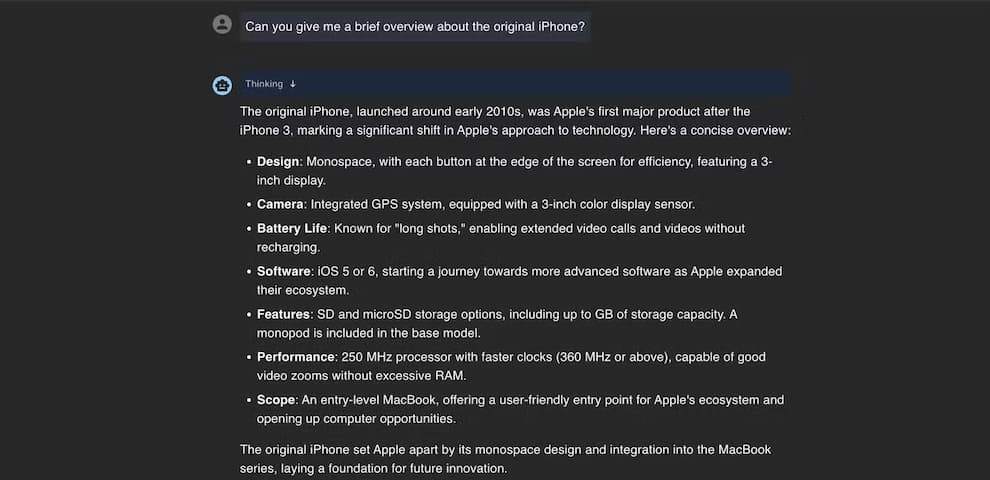

مثلاً اگر چند ساعت بعد از رویداد معرفی iPhone 17 از چتبات در مورد آن بپرسید، احتمال زیادی وجود دارد که پاسخ شامل حدسهای قدیمی و اطلاعات ساختگی باشد. بهجای استفاده از منابع رسمی اپل، چتبات ممکن است بر اساس شایعات گذشته یا روندهای قبلی پاسخ دهد، پاسخی که شاید ظاهراً درست به نظر برسد، اما بخشی از آن کاملاً اشتباه باشد.

دلیل این موضوع این است که مرور لحظهای اینترنت در بسیاری مواقع بهدرستی کار نمیکند. بعضی صفحات هنوز ایندکس نشدهاند، ابزار ممکن است از نسخه کش شده استفاده کند یا به دادههای پیش آموزشی بازگردد. از آنجا که پاسخ نرم و با اعتمادبهنفس ارائه میشود، ممکن است اصلاً متوجه اشتباه بودنش نشوید.

بنابراین برای اطلاعات حساس به زمان مانند پوشش زنده رویدادها، اعلامیههای محصول یا نقدهای اولیه، مدلهای زبانی همچنان غیر قابل اعتمادند. در این موارد، استفاده از موتور جستوجوی سنتی و بررسی منابع اصلی گزینه بهتری است.

نتیجهگیری

در نهایت، موضوعاتی هستند که نباید در آنها به چتباتهایی مثل ChatGPT اعتماد کرد. اگر درباره قوانین حقوقی، مشاوره پزشکی، سیاستهای سفر یا هر موضوع حساس زمانی سؤال دارید، حتماً از منابع دیگر هم بررسی کنید. این ابزارها برای ایدهپردازی یا درک اولیه از مفاهیم مفید هستند، اما جایگزین تخصص انسانی نیستند و تصور اینکه هستند، میتواند شما را به دردسر بیندازد.

منبع makeuseofsource